Евгений Свердлов: «Взгляд на жизнь через окно генома». Глава 2: «Основные философские концепции и Big Data». Отрывок

06 марта 2021

Евгений Свердлов: «Взгляд на жизнь через окно генома». Глава 2: «Основные философские концепции и Big Data». Отрывок

- 658

- 1

- 0

Е. Д. Свердлов. Взгляд на жизнь через окно генома. Т. 2: Очерки современной молекулярной генетики. М.: «Наука», 2019. — 495 с.

-

Автор

-

Редактор

Мы публикуем отрывок из второго тома трилогии знаменитого молекулярного биолога Евгения Давидовича Свердлова «Взгляд на жизнь через окно генома». В отличие от тома 1, в котором освещались в основном вопросы структуры и функций геномов и связанных с ними регуляторных молекул, здесь делается акцент на сложные системы, в работе которых геном либо принимает непосредственное участие, либо инициирует их независимое функционирование. В связи с этим внимание читателя обращается на философские проблемы, связанные с появлением характерных для таких систем непредсказуемых эмерджентных свойств, и указывается на существование некоторых нерешаемых проблем биологии подобно тому, как в физике существует принцип неопределенности. Большое внимание уделяется и стохастическим процессам, которые также вносят непредсказуемость в функциональные свойства биологических систем. В связи с этим рассматривается роль постоянно возникающих при функционировании генома мутаций в процессах эволюции и при возникновении болезней. Помимо этого отрывка, мы также публикуем рецензию на книгу.

Часто говорят, что эксперименты следует выполнять без предварительно выработанных идей. Это невозможно. Это не только будет делать каждый эксперимент бесплодным, но даже если бы мы хотели сделать так, это не может быть сделано.

Анри Пуанкаре

Факт есть простое утверждение, которому каждый верит.

Он вне подозрений, если не признан ложным. Гипотеза является новым предположением, в которое никто не хочет верить.

Гипотеза под подозрением, пока не найдено, что она работает.

Эдвард Теллер, отец водородной бомбы

Сидней Бреннер, многократно упоминавшийся мною Нобелевский лауреат, как-то написал: «Однажды я высказался, что все дипломники-биологи делят историю на две эпохи: последние 2 года и все остальное перед этим, где Архимед, Ньютон, Дарвин, Мендель и даже Уотсон с Криком населяют спрессованную во времени вселенную, как беспокойные современники» [1].

Читая лекции студентам, я тоже отмечал нечто подобное. И эта глава — попытка немного выйти за пределы той спрессованной вселенной, о которой говорил Бреннер. Я хорошо понимаю, как получается эффект спрессованности: нет времени отвлекаться от весьма конкретных задач, которые стоят перед дипломником и аспирантом, да и перед всеми нами — участниками нелепой гонки за публикациями в престижных журналах, грантами и прочими знаками успешности в современной молекулярно-биологической науке. Еще одно обстоятельство, способствующее такому прессованию: ученые редко пишут о том, как делается наука, и еще реже пытаются найти закономерности в ее развитии. «Одно дело быть хорошим ученым, другое — уметь хорошо описать, что делает наука. Ученые не очень хороши в таких описаниях. Их задача — делать науку, а не рассказывать о ней. Другое дело — философы науки: они тоже не очень хорошо рассказывают о науке, хотя, в отличие от ученых, — это их работа» [2]. Попробуем немножко выйти за рамки наших рутинных проблем, но сначала определим термины для дальнейшего использования.

Прежде всего, давайте договоримся о таких фундаментальных научных терминах, как факт, теория, гипотеза и закон. Сразу скажу, что есть очень много определений этих понятий, и я буду использовать только те, которые рекомендованы в солидных источниках [3].

А вот примеры опровергнутых (фальсифицированных) фактов. До Галилея «фактом» было, что тяжелые объекты падают быстрее, чем легкие. Химический «факт», что существует только три физических формы углерода — алмаз, уголь и графит, был опровергнут.

Вот несколько высказываний про факты:

- «Нет фактов, есть только их интерпретации». — Ф. Ницше.

- «Факты — враг истины». — М. Сервантес.

- «Факты упрямы, но статистика более сговорчива». — М. Твен.

- «Сначала получите свои факты, а затем можете искажать их сколько как вам угодно». — М. Твен.

Есть множество других формулировок, но суть понятна. Важно иметь в виду, что научный факт, закон и теория — три разных типа понятий.

Закон описывает, что происходит в природе при определенных обстоятельствах, и предсказывает, что это всегда будет происходить при данных обстоятельствах. Теория объясняет механизмы природных явлений, в том числе законов.

Пример данных: Joe, Smith, 1234, Circle, SLC, UT, 84084, 8015553211

Пример информации: Joe Smith, 1234 Circle, Salt Lake City, UT 84084, (801)555-3211

Формально термин «база данных» относится к набору взаимосвязанных данных и способу его организации. Использование этих данных обычно предоставляется «системой управления базами данных» (СУБД), (database management system, DBMS), состоящей из интегрированного набора программных продуктов, который позволяет пользователям взаимодействовать с одной или несколькими базами данных и обеспечивает доступ ко всем данным, содержащимся в базе данных (хотя могут существовать ограничения доступа к определенным данным). СУБД предоставляет различные функции, которые позволяют ввод, хранение и поиск больших объемов информации и дает способы управления организацией этой информации. Из-за тесной связи между понятиями «База данных» и СУБД, термин «база данных» используется рутинно, чтобы обозначить и базу данных и СУБД, используемую для управления ею.

Пирамида знания «Данные → Информация → Знание → Мудрость»

Пирамида знания (Data-Information-Knowledge-Wisdom, DIKW-пирамида), известная также как «DIKW иерархия», «Иерархии Мудрости в иерархии знаний», «Информационная иерархия» используется для представления подразумеваемых структурных и/или функциональных связей между данными, информацией, знаниями и мудростью.

Не все версии DIKW модели содержат все четыре компонента (более ранние версии не включают данные, более поздние версии опускают мудрость), а некоторые включают дополнительные компоненты.

После долгих размышлений, какой критерий выбрать для представления этого материала себе, студентам и другим неспециалистам в области информатики, я решил взять за основу одну из наиболее цитируемых популярных работ, представленных в интернете. Эта статья цитируется 368 раз и достаточно популярно излагает проблему. Статья называется «Данные, информация, знание и мудрость» (Data, Information, Knowledge, and Wisdom) или короткий вариант [6]. Можно получить информацию также в обзоре [7]. Согласно этой модели, структура человеческого сознания может быть классифицирована в четыре категории, приведенные в таблице 1.

| Категория | Пример | Объяснение | Развернутый пример |

|---|---|---|---|

| Данные | Символы | Данные являются сырьем. Они просто есть и не имеют никакого значения, кроме самого факта их наличия. Они могут существовать в любой форме, полезной или нет, без связи друг с другом или другими данными. | — |

| Информация | Данные, преобразованные так, чтобы быть полезными; отвечают на вопросы «кто», «что», «где», и «когда» | Информация представляет собой упорядоченные данные, которым был придан смысл посредством установления какой-либо взаимосвязи между отдельными данными. Информация включает элементы понимания связей между данными. | Идет дождь. Температура упала на 15 oC, и затем пошел дождь |

| Знание | Использование данных и информации. Отвечают на вопрос «как» | Знание представляет собой систему, которая соединяет элементы информации и, в целом, обеспечивает высокий уровень предсказуемости на основе описанных дальнейших событий | Если влажность очень высока и температура значительно понижается, атмосфера не в состоянии удерживать влажность, и в результате пойдет дождь. |

| Мудрость | Связывает фундаментальные принципы, заключенные в знании | Мудрость охватывает большее понимание фундаментальных принципов, содержащихся в знании. Она способна предсказывать будущее развитие процессов на основе предыдущего знания. | Понимание того, почему идет дождь, охватывает понимание всех взаимодействий, происходящих между дождем, испарением, воздушными потоками и изменением градиентов температуры. |

Первые три категории относятся к прошлому опыту. Только четвертая категория относится к способности предвидеть будущее. Существует множество разных трактовок элементов пирамиды. То, что вы увидели, — это пример одной из них. Я не знаю, насколько такие модели полезны для понимания того, как добывается новое знание. Предоставляю судить вам самим. Замечу только, что дальше вы познакомитесь с мыслями выдающихся философов о том, как развивается наука, и, боюсь, не найдете там места красивой пирамиде.

Элементы философии науки

Давайте попытаемся осмыслить, что произошло за последние 10–15 лет в науке, и как нам двигаться дальше. Чтобы делать это осмысленно, нужно посмотреть на произошедшие события с некой философской точки зрения. Этого нам часто не хватает для правильной оценки перспектив развития. И чтобы у нас с вами была корректная концепция, стоит ознакомиться (конечно, очень фрагментарно, в приложении к нашим конкретным проблемам) с философией Карла Поппера (1902–1994) [8] и Томаса Куна (1922–1996). Зачем? Потому что нас с вами не очень правильно учили. Учили проводить эксперименты. Это очень хорошо. Чем больше экспериментов ставил аспирант или научный сотрудник в день, тем он был более ценным. Но совершенствование технологий всё больше идет к тому, что эксперименты будут ставить роботы [8]. И делать они это будут с очень высокой скоростью.

Вот выдержка из редакторской статьи, опубликованной в 2004 году в Nature: «Группа британских ученых разработала автоматическую систему, которая порождает гипотезы для объяснения наблюдений, разрабатывает эксперименты для тестирования этих гипотез, выполняет эти эксперименты, используя лабораторных роботов, интерпретирует результаты, чтобы отбросить — (falsify, обратите внимание на этот термин, мы с ним еще столкнемся) — гипотезы, не согласующиеся с экспериментальными данными, и затем повторяет цикл». Благодаря новой системе, ученые скоро смогут проводить меньше времени, формулируя и тестируя гипотезы, и больше времени, выполняя «креативные скачки вперед, в чем они превосходят [робота]». Это происходит уже сейчас в области секвенирования. Раньше мы секвенировали вручную. Я отбирал студентов в лабораторию по принципу, получается или нет у него сиквенс. А теперь это коммерческое предприятие: плати деньги, и тебе фирма насеквенирует, сколько заплатишь.

Поток данных затопляет компьютерные мощности. Чрезвычайно остро стоит вопрос: «что с ними делать дальше?»

Многие десятилетия в нарастающем темпе увеличивалась скорость компьютеров. Сегодня наступило время, когда скорость накопления данных в геномике происходит быстрее, чем компьютеры в состоянии их обрабатывать. Один ДНК-секвенатор теперь производит в день больше данных, чем это было возможно за десять лет, когда выполнялся проект «Геном человека». Поток данных затопляет компьютерные мощности [10]. И поэтому чрезвычайно остро стоит вопрос: «А что с ними делать дальше?». Мы это увидим по ходу дальнейшего изложения. И здесь не обойтись без философского осмысления возможностей и направлений дальнейшего движения, чтобы оно перестало быть бегом на месте, как, на мой взгляд, всё более и более это и происходит. Это мы тоже увидим.

Наука не доказывает теории. Научные измерения могут только опровергнуть теорию или согласовываться с ней

Если вы думаете, что наука это что-то определенное — это ошибка с вашей стороны

Ричард Фейнман

Чтобы начать, традиционно воспользуемся цитированием. Журнал Science 6 мая 2011 года в разделе «Новости недели» озаглавил одну из новостей так: «Наконец спутник Gravity Probe B доказал правоту Эйнштейна». Казалось бы, что такого? Доказал правильность теории. Но вот один из читателей журнала, по фамилии Беннетт (Charles L. Bennett), в том же журнале, но 10 июня, написал письмо редактору: «Заголовок [новости] вызвал у меня раздражение. Я часто повторяю студентам и публике, что наука не доказывает теории. Научные измерения могут только опровергнуть теорию или согласовываться с ней. Любая теория, которая связана с измерениями, может быть в дальнейшем опровергнута последующими измерениями. Я никак не ожидал, что журнал Science может сказать: “Теория была «доказана”».

Ответ редакции: «Беннетт полностью прав. Это важная концептуальная позиция, и мы пропустили это».

Для большинства людей (и даже научных работников), — это звучит диковато. Ну как же так?! Разве наука не доказала закон всемирного тяготения наряду с другими законами механики Ньютона? Вот что написал в своей статье, опубликованной в PLoS Biology в 2011 г., А. Мейер [11]:

«Философия — старейшая дисциплина, которую начали изучать в местах, известных теперь как университеты. Многие читатели этого журнала имеют степень PhD, т.е. номинально доктора философии. Это, конечно, пережиток истории, которая отсылает к древним грекам и основана на примате философии над другими академическими профессиями. Но большинство ученых (включая меня) никогда не изучали философии науки. Я готов спорить, что только незначительное число работающих ученых могли бы приостановить научную работу и спросить себя: Как работает наука? Как происходит ее прогресс? Есть ли вообще прогресс в науке? Как приобретается и накапливается знание?

Ученые абсолютно уверены, что прогресс есть, но, возможно, вас удивит, что философы и другие ученые в гуманитарной области могут так не думать. …Ученые сегодня слишком заняты, они думают, как опубликовать статью в таком журнале, как PLoS Biology, или как получить следующий грант… Если на них нажимать, некоторые исследователи могут, следуя рекомендации Карла Поппера, заявить, что они строят свои эксперименты в попытке опровергнуть гипотезу, которую кто-то выдвинул в их области исследований. Но в моменты, когда контроль над ними отсутствует, они предпочтут сказать, что они собирают доказательства за, а не против их излюбленной гипотезы».

Сказанному вторит Питер Липтон [2] в обзоре, посвященном лекции, прочитанной в 2004 году Питером Медаваром, нобелевским лауреатом, иммунологом и философом науки: «Отношение ученых к философии науки варьирует от безразличия до определенной враждебности. …Философия не может прямо улучшить практические успехи науки, но ученым может быть интересно узнать, как наука работает и чего она может достичь… Современное состояние философии науки иллюстрируется недавней работой по “гипотезе истины” (truth hypothesis), согласно которой наука генерирует всё более точное представление о независимом от сознания (mind-independent) и в большей своей части ненаблюдаемом мире».

В этой же статье он говорит: «Иногда философия всё же помогает. Но если даже нет, то можно стать на точку зрения, что никто и не предполагает, что она может дать какие-либо практические выводы. Астрономия не претендует на то, чтобы улучшить поведение галактики. Наука настолько важна, что она стоит того, чтобы попытаться понять лучше, как она работает, без надежды получить какие-либо практические выгоды. Фрэнсис Бэкон (1561–1626) писал относительно плодов и света, которые производит наука: “Свет — это понимание, плоды — технология”. Многие отрасли науки приносят и то, и другое. Но надежда на понимание сама по себе достойна того, чтобы оправдать научную деятельность. Это относится и к философии».

Я весьма далек от исчерпывающего знания философии науки, но есть две вещи, которые, на мой взгляд, заслуживают внимания каждого ученого. Это концепция Карла Поппера о необходимости подходить к доказательству истинности гипотезы или теории не с позиции накопления все новых подтверждающих наблюдений, а с позиции поиска наблюдений, опровергающих выдвигаемую гипотезу или теорию. Это мощный критический и отрезвляющий подход, который помогает избегать многих практических ошибок.

И вторая концепция — это идея Томаса Куна о том, что наука развивается путем революций. При этом она сначала работает в нормальном режиме, следуя какой-то установившейся парадигме (совокупность фундаментальных научных установок, представлений и терминов, принимаемая и разделяемая научным сообществом и объединяющая большинство его членов), затем накапливаются противоречия с этой парадигмой, а затем установившаяся парадигма сменяется новой. Практическая польза такой концепции заключается в том, что каждый ученый должен следить за фактическим состоянием той парадигмы, которой он следует, и отвечать себе на вопрос, насколько она соответствует современным научным данным. Парадигмам свойственна сильная инерционность, и следование отжившей парадигме может наносить большой вред науке. Я постараюсь дать несколько примеров того, как это происходит, пользуясь, в своей традиции, цитатами известных ученых и их малоизвестных оппонентов.

Никакое количество экспериментов не докажет мне, что я прав, единственный эксперимент может доказать мне, что я ошибаюсь.

Альберт Эйнштейн

Концепция, сформулированная в заглавии этого параграфа, была выдвинута в фундаментальной работе философа науки сэра Карла Поппера «Логика научного открытия» (The Logic of Scientific Discovery) ) [7]. В ней он выдвинул идею, что наука должна основываться не на подтверждениях, а на опровержениях (falsification). Мысль, которую он обосновал, — это что наука не может ничего доказать, но может опровергнуть идею, которая принимается за истину в настоящее время. Он даже сформулировал концепцию научности той или иной теории — теория научна, если она содержит в себе возможность собственного опровержения (обратите внимание — не подтверждения, а опровержения). Если этого нет, то гипотеза, теория — не научны. Далее мы посмотрим на всё это слегка более подробно, взяв за основу статью, написанную реально работающим биологом, а не философом, рассуждения которого могут показаться слишком сложными. Но прежде чем перейти к этому разделу, следует сделать.

Сэр Карл Поппер, лебеди и обычный терапевт

Познакомимся с теорией Поппера несколько необычным образом. Почитаем статью [11]: «Сэр Карл Поппер, лебеди и обычный терапевт». Вот какая история изложена в этой статье. «В 50 лет я уже чувствовал незначительную боль в спине. Она усиливалась, и я решил сходить к своему постоянному врачу [Дело происходит в Дании — E.С.]. Быстро и без обследования она пришла к убеждению, что оснований для беспокойства нет. Ее совет — уменьшить нервные нагрузки, не работать так много — не помог. Боль усиливалась, и через месяц я пришел опять. На этот раз врач прописала обезболивающее. Не помогло, и я пришел опять и попросил назначить мне рентгеновское обследование. Врач была против и объяснила мне вред рентгеновского излучения. Только после сильного нажима она согласилась. Радиография нижней части спины не выявила серьезных нарушений. Но боли усиливались, становилось все труднее стоять и ходить. В Дании постоянный врач играет ключевую роль. Она отказалась показать меня невропатологу. И я отправился в Бельгию (А вы говорите Россия! — Е.С.). Этот невропатолог назначил магниторезонансную спектроскопию всей спины, а не только нижней части, где я ощущал боль. Этот анализ показал, что у меня раковая опухоль вокруг легких и желудка, она уже начала давить на позвоночник. Химиотерапия и аутологичные стволовые клетки помогли. Глядя на мою историю, я понял важность философии Карла Поппера. В частности, его взгляды на истину прямо относятся к медицине и моему врачу. Способ, которым врач пытался найти истину, был прямо противоположен попперовским идеям. Врач искал подтверждения своему первоначальному диагнозу. Как Поппер говорил — если вы видите много белых лебедей, это не значит, что все лебеди белые. Вы должны искать черного лебедя. Этот так называемый принцип опровержения (фальсификации) имеет громадное значение в философии науки и в способах, которыми в эмпирической науке добывается знание. Кратко, он заключается в формулировке гипотезы, которую можно проверить (гипотеза, которую проверить нельзя, — ненаучна), и затем пытаться ее опровергнуть (не подтвердить, как это делал врач). Только таким путем, полагал Поппер, можно приблизиться к истине». (Я использую попперовский подход в этой книге: всегда стараюсь найти точки зрения скептиков в море позитивов. Вы это увидите дальше.)

Автор статьи [12] заканчивает ее мыслью, что в медицинском образовании уделяют недостаточно внимания философии науки вообще и философии Поппера, в частности. Я думаю, что эта проблема существует не только в медицинском образовании. Конечно, я не собираюсь (и не смог бы) дать полный анализ философии науки, но, мне кажется, будет небесполезно поговорить немного о философии Карла Поппера и Томаса Куна. Это тем более важно, что наша с вами наука находится явно в кризисном состоянии и нуждается в смене парадигмы. Непонятно? Вот и попытаемся это понять.

Взгляд биолога на философию Поппера

Статья, которую я полагаю очень подходящей для всех, читающих эту книгу, называется «Применения Карла Поппера» (The Uses of Karl Popper). В ней говорится, что достижение Карла Поппера революционно — он разрушил философию индуктивизма, которая лежала в основе логики научного познания сотни лет. Приведу вкратце содержание статьи.

Предельно упрощенные тезисы теории индуктивизма:

- Наука стремится к обоснованному, доказанному знанию, к четко определенной истине.

- Все научные исследования начинаются с наблюдений или экспериментов.

- Данные наблюдений или экспериментов организуются в форме гипотез, которые еще не доказаны (context of discovery).

- Наблюдения или эксперименты повторяются много раз.

- Чем больше число успешных экспериментов, тем выше вероятность, что проверяемая гипотеза истинна (context of justification).

- Как только мы удовлетворены и полагаем, что достигли определенности, мы отставляем проблему в сторону навсегда и считаем, что теперь мы имеем дело с доказанным законом природы.

- Затем мы так же решаем следующую проблему.

- Соединяя все доказанные таким образом теории, мы строим величественное здание обоснованной и определенной науки.

Суммируя, можно сказать, что подход к науке заключается в движении от частностей (particulars) к общему, и что справедливость частных данных переносится на общую теорию.

Предельно упрощенные тезисы теории дедуктивизма Поппера

Теория Поппера может быть названа дедуктивизмом. Следуя тому же принципу, что использован при описании индуктивизма, она может быть описана следующими тезисами:

- Наука стремится к абсолютной и объективной истине, но никогда не может достичь окончательной определенности.

- Все научные вопросы (исследования) начинаются с материала какого-либо первоначального (исходного) знания, с проблем, связанных с этим исходным знанием, и с тем, что Поппер назвал метафизической исследовательской программой (metaphysical research programmes). Мне не нравится этот термин, он у многих вызывает представление о привлечении каких-то мистических явлений для объяснения причин реально наблюдаемых явлений. Поэтому мы с вами будем им пользоваться только как термином, означающим, что для того чтобы объяснить наблюдаемые явления, мы выдвигаем гипотезу о том, что существуют какие-то неизвестные, но материальные механизмы, которые вызывают наблюдаемые эффекты.

Далее мы выдвигаем предположение, гипотезу, о их сути и предлагаем эксперименты для проверки этой гипотезы. Метафизика здесь не значит ничего более, чем что-то материальное, но не наблюдаемое доступными физическими опытами. И вполне допускает, что при совершенствовании технологий это что-то может наблюдаться. Использую в качестве примера мРНК гипотезу. Она широко известна, и я постараюсь выделить из нее только элементы, демонстрирующие «метафизический» компонент. В 1960 году было известно, что генетическая информация, кодируемая ДНК, которая находится в клеточном ядре, превращается в белки рибосомами в цитоплазме. Было установлено, что рибосомы сами по себе не могут переносить генетическую информацию, необходимую для синтеза разнообразных белков, из ядра в цитоплазму. Была выдвинута гипотеза (1961 год, Жакоб и Моно), что, возможно, существует другой класс РНК, который действует как переносчик (messenger) генетической информации, синтезируется на матрице ДНК и затем транспортируется в цитоплазму. Вот здесь в качестве гипотетического метафизического компонента выступала неизвестная мессенджер РНК (мРНК). Это была проверяемая гипотеза. мРНК была экспериментально обнаружена Бреннером, Жакобом и Мезельсоном в 1964 году, потеряв свою метафизическую загадочность.

Или вот еще. Всем известен закон всемирного тяготения Исаака Ньютона, открытый им в 1666 г. Он гласит, что сила гравитационного притяжения между двумя материальными точками массы, разделенными неким расстоянием, пропорциональна обеим массам и обратно пропорциональна квадрату расстояния между ними. Закон был чисто математическим и никак не объяснял силы, которые к нему приводят. Эти ненаблюдаемые силы с точки зрения выше принятой попперовской формулировки могут временно рассматриваться как метафизические. Ньютон пытался, но не преуспел создать теорию тяготения, которая объяснила бы, какие силы обусловливают существование закона. В 1915 году, с созданием общей теории относительности Эйнштейна, гравитация получила объяснение. Закон Ньютона оказался одним из следствий этой более общей теории. - Таким образом, гипотеза (теория) представляет собой предполагаемый ответ на проблему. Она объясняет наблюдаемые эффекты с привлечением гипотетических, ненаблюдаемых механизмов.

- Из теории выводятся экспериментально проверяемые следствия и проводятся соответствующие эксперименты для проверки предсказаний.

- Если получаемый экспериментальный результат соответствует предсказанному, он рассматривается как довод в пользу продолжения экспериментов в рамках теории, но он не рассматривается как элемент доказательства теории ненаблюдаемого.

- Как только любой новый результат не согласуется с теорией, она считается опровергнутой (falsified), но только предварительно.

- С учетом этого результата мы получаем более глубокое понимание нашей проблемы и меняем или усовершенствуем теории для решения проблемы. При этом далее мы действуем тем же путем.

- Цепь всех этих гипотез и опровержений составляет динамику научного прогресса, каждый раз приближаясь к истине, но никогда не достигая ее. Теории заходят гораздо дальше, чем данные, которые лежат в их основе. Иначе теория будет неинтересной. Это означает, что теория всегда недостаточно подкреплена данными. Поэтому теорию невозможно доказать имеющимися данными [2].

Дедуктивизм утверждает, что наука движется от общего к частному и обратно — и это бесконечный процесс. Поскольку эта проблема очень важна, и дедуктивное и индуктивное часто путают, я еще немного времени уделю объяснениям. Использую материал из статьи в Интернете. В дедукции логическая аргументация начинается с общего утверждения, или гипотезы. Мы прогнозируем, какие факты должны быть, если теория была правильной. Мы идем от общего (гипотезы) к частному (наблюдениям, фактам) и рассматриваем возможности для достижения определенного логического вывода. Научный метод использует дедукцию для проверки гипотез и теорий.

В дедуктивном рассуждении, если что-то истинно для класса вещей в целом, это также справедливо для всех членов этого класса. Например, «Все люди смертны. Гарольд человек. Следовательно, Гарольд смертен». Дедуктивные выводы верны при условии, что исходные допущения верны. Если это не так, вывод может быть логичным, но при этом оказаться неверным. Например, аргумент: «Все лысые мужчины дедушки. Гарольд лысый. Поэтому, Гарольд дедушка» логичен, но не соответствует действительности, потому что первоначальное заявление является ложным. Индуктивная логика делает широкие обобщения из конкретных наблюдений. В индуктивном мышлении мы идем от частного к общему. Мы делаем много наблюдений, делаем обобщение и вывод или теорию, объясняющую наблюдения. При этом, даже если все посылки истинны в заявлении, индуктивный вывод может быть ложным. В примере «Гарольд дедушка, Гарольд лысый. Следовательно, все дедушки лысые» вывод логически не следует из исходных фактов.

В этой истории заключается обоснование «попперизма». В каждый момент мы не располагаем исчерпывающим набором знаний, характеризующих исследуемый объект и его взаимодействия с окружающей средой. (Представьте себе на минутку сложность даже простейшей живой клетки.) Так что наши выводы об объекте с неизбежностью не являются исчерпывающими. Поэтому даже самые, казалось бы, незыблемые догмы науки в какой-то момент могут быть опровергнуты. «Ученые никогда не останутся без работы. Наука никогда не даст окончательного результата» [2].

Конечно, очень многие экспериментаторы не принимают попперовскую гипотезу. Вот, например, что пишет Д. Гласс: «Ученые часто руководствуются условностями, финансирующими агентствами и правилами журналов и проводят работу в рамках определенной гипотезы, хотя Исаак Ньютон считал, что гипотезе нет места в экспериментальной науке (Ньютон тоже мог ошибаться. — Е.С.). Некоторые могут полагать, что предостережение Ньютона недействительно для современных экспериментальных методов, так как, согласно Карлу Попперу, современная гипотеза строится как средство опровержения, а не подтверждения. Но этот подход тоже проблематичен. Его обвиняли в философской непоследовательности, неприменимости к современной большой науке (large science), такой как системная биология, несовместимости с действительно актуальными целями экспериментальной науки, которые заключаются в подтверждении, а не опровержении» [13].

А вот еще более резкая критика [14]: «..биологи должны прекратить цитирование Карла Поппера, когда речь идет об истинно научной теории ... Установившийся взгляд, что истинно научная теория должна содержать возможность экспериментального опровержения, — это серьезная ошибка, и что реальная точка зрения Поппера заключалась в том, что истинно научные теории имеют форму утверждения законов природы (statements of laws of nature)». Авторы далее утверждают, что биология не имеет собственных законов природы, и предлагают свои замены попперовской философии.

Естественно, мы с вами далеки от философии и не будем вступать в дискуссии на философские темы. Мы просто знакомимся с теми концепциями, которые, на взгляд очень многих выдающихся ученых, сыграли и продолжают играть важную роль в выработке правильных оценок научности и перспективности той или иной теории, выдвигаемой в области биологии. Но вот даже выдающиеся учёные не всегда разделяли подход Поппера.

Теперь поговорим о Томасе Куне и его концепции научных революций и смены парадигм

Вооруженное всеми возможностями, наслаждаясь всем богатством, которым оно обязано науке, наше общество всё еще пытается практиковать и учить системам ценностей, уже уничтоженных в корне этой самой наукой.

Жак Моно

В статье, опубликованной в 2012 году в Science, мы прочтем следующее: «С того момента как книга Куна „Структура научных революций“ [15], была опубликована в 1962 г., было продано более 1 миллиона экземпляров, и она была переведена на 16 языков. Эта книга — редчайшее событие: академический бестселлер. Возьмите список 100 наиболее влиятельных книг XX века, или даже наиболее влиятельных книг всех времен, и очень вероятно, что она окажется в этом списке» [16]. До Куна историки науки полагали, что наука развивается постепенно, добавляя новые блоки знания к уже существующим. Кун выдвинул идею, что прогресс происходит революционными скачками путем появления новых парадигм. Парадигма по Куну — это пример (exemplar): конкретное решение проблемы в данной области, которое направляет другие исследования в этой области. Этими парадигмами могут быть новые теории, новые технические методы, которые открывают новые возможности наблюдения и анализа.

Кун разделяет развитие науки на различные периоды:

- В науке наблюдаются периоды, названные им нормальной наукой, normal science, в которых преобладает поразительное согласие между исследователями. Это поразительно, поскольку нет никаких официальных правил, которыми руководствуются исследователи. Однако они действуют однотипно в выборе новых проблем, выборе методов исследования и стандартов решения. Что определяет согласованное поведение в отсутствие официальных правил? Ответ Куна — примеры (exemplars), которые действуют как правила и используются по принципу сходства [2]. Томас Кун говорил, что ученые в своей работе начинают с изучения типичной (exemplary) проблемы, а не с выработки общих правил исследования. Успешные примеры стимулируют исследователей браться за сходные проблемы сходными методами, сходной логикой и со сходной оценкой получаемых результатов. Постепенно накапливается научное знание. Это будет показано потом на нескольких примерах.

- Затем наступает кризисный период, когда примеры продолжают порождать новые проблемы, но перестают находить адекватные решения. Неразрешимые проблемы накапливаются, стройная система представлений становится шаткой, многие казавшиеся надежными представления вдруг оказываются не такими надежными, как казались.

- Наконец, наступает период научной революции, когда набор парадигм отбрасывается в пользу других. Появляются новые идеи, новые технологии, которые позволяют отвергнуть отжившие части научной структуры и сделать следующий шаг к истине.

Как писал С. Бреннер [1]: «Часто новая волна встречает сильное сопротивление, но, как указывал Макс Планк, она побеждает, потому что оппоненты стареют и умирают. Процесс затем повторяется. Радикалы становятся либералами. Либералы становятся консерваторами, консерваторы реакционерами, и реакционеры исчезают. Студенты, изучающие эволюцию, узнают здесь процесс прерывистого равновесия (punctuated equilibrium): организмы остаются неизменными очень долгое время, которое прерывается взрывом, когда появляются новшества, и затем опять наступает стагнация».

Наиболее важной характеристикой парадигмы является ее плодотворность

После научной революции мир меняется. Автор, упомянутой статьи в Science [16] высказывает такую мысль: «Интересное свойство парадигм — то, что они не являются открытием в традиционном смысле. Они не представляют собой разработанные блоки знаний. Им не требуется изначально быть приблизительно правильными или высоко вероятными. Вместо этого наиболее важной характеристикой парадигмы является ее плодотворность. По мере того как развивается наука, в нормальной стадии накапливаются исключения и трудности. Согласно теории Поппера появление исключений или любых аномалий требует, чтобы теория была отвергнута и пересмотрена. Кун не согласен... До тех пор, пока парадигма остается полезной для выработки теории и практических приложений, аномалии просто накапливаются, их терпят или как-то объясняют (незначительные исключения, экспериментальные ошибки и т.д.).

Исследовательские группы почти никогда не отказываются от программы просто потому, что она выявляет аномалии. Эти аномалии приобретают значение, только когда парадигма перестает быть продуктивной, или когда исследователь начинает беспокоиться относительно исключений настолько, что у него возникают сомнения в правильности парадигмы. Когда это происходит, возникает революция. Но, важно, революция — не просто полное отрицание старой парадигмы, это не логическое опровержение теории, как это рекомендовал бы нам Поппер. В центре научной революции может быть ряд конкурирующих вариантов для исследования. Адвокаты новой парадигмы борются с адвокатами старой. (см. выше высказывание Бреннера. — Е.С.). Следует ли просто подлатать старую парадигму или ее следует полностью сменить новой? Кун считал, что эти вопросы не решаются просто призывами к разуму и фактам».

Здесь я отклонюсь от текста автора, поскольку в нем содержатся неточности, но использую его пример. Борьба с теорией флогистона в химии продолжалась десятки лет, и победа была достигнута не столько путем неопровержимых доказательств, сколько потому, что работающие в то время химики пришли к выводу, что подход Лавуазье (определение изменения массы горящих веществ) более плодотворен. Каков с точки зрения Куна статус новой постреволюционной парадигмы по отношению к старой? Кун отвечал, что они просто несопоставимы (incommensurable).

Далее продолжу цитирование [16]: «Тезис несопоставимости — это наиболее противоречивая идея Куна. Она утверждает, что когда ученые меняют парадигмы при научной революции, старые важные термины или концепции изменяют свой смысл или вообще перестают быть осмысленными в контексте новой парадигмы». Я думаю, что этот тезис в большинстве случаев неприменим, но детальное рассмотрение этой проблемы не входит в мои планы.

Основное в теории Куна — это смена парадигм и научные революции, а не взаимоотношения старой и новой парадигм. И концепция смены парадигм и научных революций является сама по себе революцией. Смена парадигм может иметь глобальный характер, как это имело место с появлением структуры двуспиральной ДНК в биологии, или она может происходить в локальных областях науки, как, например, в области регуляции экспрессии генов. Революция, совершенная открытием ДНК, всем известна.

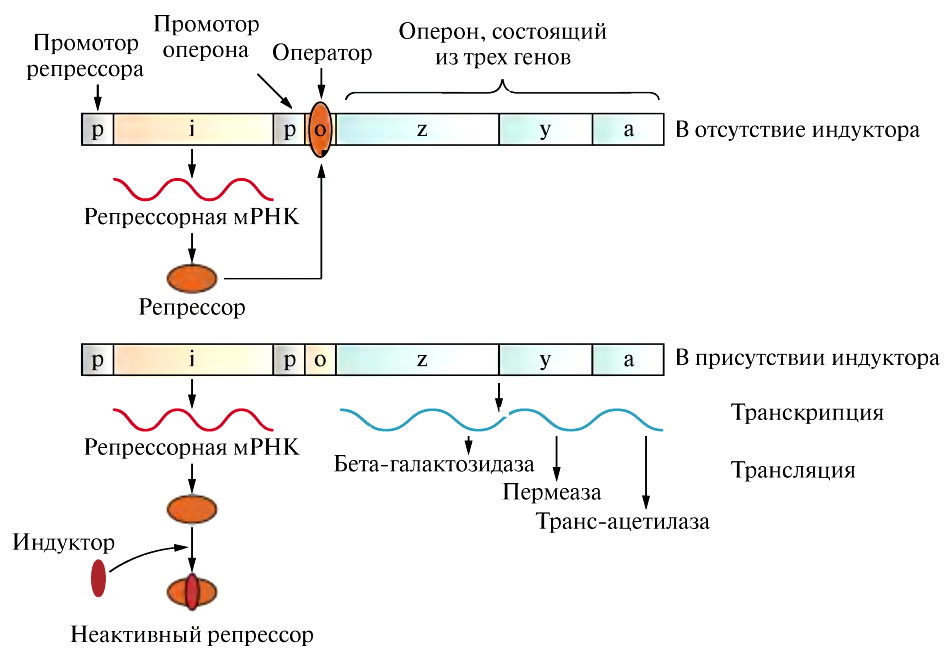

Парадигма, которая инициировала молекулярную биологию регуляции генов

Механизм регуляции генов, предложенный Ф. Жакобом и Ж. Моно с соавторами, один из которых написал статью, использованную мной для данного параграфа, функционировал как революционная парадигма в точности так, как это описал Кун. В предшествующий период выдвигалось множество теорий, пытающихся объяснить, как регулируется синтез белков. Статья Жакоба и Моно внесла ясность в область, где множество довольно мутных теорий конфликтовали друг с другом. Жакоб и Моно работали с кишечной палочкой. Кроме того, я уверен, что вы прекрасно знаете теорию, основанную на регуляции лактозного оперона. Тем не менее, на рис. 1 я дал самую простую схему регуляции этого оперона вместе с портретами нобелевских лауреатов 1965 г., награжденных за открытие регуляции синтеза ферментов и вирусов. Эта простая схема была настолько убедительной, имела такое серьезное экспериментальное обоснование и, к тому же, она предлагала общую концепцию регуляции, которая с совершенной очевидностью могла быть использована во множестве других случаев. Кроме того, Жакоб и Моно создали модель выстраивания экспериментов для исследования регуляторных механизмов генетических систем. Множество ученых, исследовавших регуляцию в бактериальных клетках, подхватили эти идеи и методы и начали применять их к своим системам. Следует отметить, что большую роль в быстром признании парадигмы сыграла ее простота. В своей нобелевской лекции Моно сказал: «Красивая модель может быть неправильной, но уродливая обязана быть неверной».

Рисунок 1. Классический пример парадигмы: негативная регуляция lac-оперона в бактериях. Уровни глюкозы и лактозы контролируют инициирование транскрипции Lac-оперона. В клетке E. сoli, растущей в отсутствие лактозы, репрессорный белок связывается с оператором, не позволяя РНК-полимеразе транскрибировать гены Lac-оперона. Оператор выключен. Когда добавляется индуктор (лактоза), он связывается с репрессором и предотвращает связывание с оператором. Пока оператор свободен от репрессора, РНК-полимераза может транскрибировать структурные гены оперона в мРНК. Оперон включен.

Были, конечно, и другие факторы, которые способствовали утверждению теории Жакоба и Моно в качестве парадигмы. Они были признанными учеными, их результатам и интуиции доверяли, они были прекрасными ораторами и писали свои статьи в чрезвычайно научном и убедительном стиле. Эти, казалось бы, побочные обстоятельства часто играют первостепенную роль в утверждении парадигмы, но не в длительности ее существования. Последнее определяется всецело ее плодотворностью. 10 лет (большой срок, хорошая парадигма), последовавших после презентации теории репрессии как способа регуляции генов, знаменовали собой период нормальной науки.

В 1965 г., однако, стали появляться сомнения — позитивный контроль в случае арабинозного оперона. Тем не менее, прошло еще несколько лет перед тем, как молекулярно-биологическое сообщество признало, что могут быть и другие пути регуляции. Это во многом объясняется жесткой позицией Жакоба и Моно, отрицавших возможность любых других вариантов регуляции, кроме репрессии. (Классика эволюции парадигмы. См. выше высказывания Бреннера). Вот что пишет Дж. Беквис в своем обзоре [17]: «Харрисон Эхолс рассказывает о персональном опыте, который иллюстрирует силу Моно в защите своей теории. Харрисон в докладе о регуляции синтеза щелочной фосфатазы в 1961 г. упомянул, что контроль может быть позитивным — регуляторный продукт может быть индуктором, требуемым для включения фосфатазного гена. Моно вышел вперед и воскликнул : “Нет, нет, мы знаем, что вся регуляция негативна”. После чего Харрисон решил, что будет лучше переключиться с фосфатазы на другой объект». Такие примеры не единичны. Мы будем с ними еще сталкиваться.

Я пишу об этом, чтобы исследователи всегда помнили, что смена парадигм — это процесс борьбы и жесткого сопротивления старой парадигмы. И, тем не менее, примерно через 10 лет после первой статьи Жакоба и Моно стало пробиваться понимание, что возможны разные варианты регуляции. Обнаружились гены или опероны с множественными системами контроля. Первым прорвался контроль арабинозного оперона активатором, т.е. позитивный контроль. В 1969 году соответствующие статьи, наполненные многочисленными данными, убедили скептиков, что репрессорная регуляция не объясняет всего разнообразия способов регуляции. Быстро последовали данные по позитивной регуляции других генов. Затем выявились и другие механизмы регуляции. И вот заключительная фраза из рассматриваемого обзора: «Мы можем и до сих пор фокусироваться на „простейших“ объяснениях наших данных, но под ними прячется потенциально огорчительное знание, что ничто не бывает таким простым, как мы это воображаем». И это так, по крайней мере, в биологии, как бы соблазнительны ни были простота и красота и авторитет Эйнштейна и Гейзенберга.

Говорят, что ошибочные взгляды такого авторитета как Аристотель сковали развитие науки на века. Он, как известно, считал, что планеты должны двигаться по кругу просто потому, что это наиболее совершенная фигура.

Новые парадигмы или путь в новый тупик — омики, системная и синтетическая биология. Много споров — минимальные результаты

Напомню сказанное выше: Парадигмы не обязаны быть открытиями в традиционном смысле. Они не представляют собой разработанные блоки знаний. Им не требуется изначально быть приблизительно правильными или высоко вероятными. Вместо этого наиболее важной характеристикой парадигмы является ее плодотворность [16]. И обсуждение, приносят ли омики новую парадигму, которая заменяет старую молекулярную биологию, начну, как всегда, с цитирования.

На этот раз это будет очень интересная статья Геральда Вейссмана, главного редактора журнала The FASEB Journal (статья написана очень эмоционально, и мне придется цитировать близко к тексту, но не дословно): «Мы не только готовы к геномной революции, мы находимся посреди следующей. Я осознал это, когда стал искать в словарях слово, новое для меня... „убиквитом“ (ubiquitome). Я понял. Неологизм или нет, ubiquitome выглядит так же, как кином или протеом, метаболом — все такие „омы“ выпрыгивают сегодня часто. Все это называется омиками (omics) по аналогии с геномикой».

Итак, мы глубоко в омиковой революции. Существует журнал Omics, учрежденный в 1995 г. Журнал определяет свои задачи так: «Вслед за успехом проекта генома человека появилось несколько других омик с целью анализа компонентов живых организмов в их цельности (entirety). Люди в области омик заняты картированием не только полных наборов белков в клетке (протеомика), но также полным набором изменений метилирования генома (эпигеномика), полным набором мутантных фенотипов (феномика), полным набором органических низкомолекулярных соединений „лигандомика“ и так далее» . Революцию омиков «освятил» Джошуа Ледерберг (нобелевский лауреат) с коллегой лингвистом: «Геномика и протеомика — это модные слова начинающегося тысячелетия... То, что большинство этих терминов — старых и новых — были придуманы как броские фразы, призванные привлечь внимание, не уменьшает их вероятную полезность, и они уже встроены в передовые рубежи науки и технологии». «Омиковая» революция не просто приносит новые факты — она изменяет способ мышления биологов. Пионеры омиков и системной биологии заявляют, что они перевернули традиционный, направляемый гипотезами, путь исследований или, как минимум, нашли альтернативный путь делать науку. Новые технологии микрочипов, картирования молекулярных взаимодействий, кинетической симуляции клеточных процессов привели к тому, что исследования, направленные на открытия (в рамках выдвигаемой гипотезы), начинают вытесняться расшифровкой информации (information-mining).

— Напомню, что слово геном было изобретено немецким ботаником Гансом Винклером, который в 1930 году назвал так сумму генов, взяв за основу название генетического материала — ген), придуманное в 1905 Йогансеном, и совместив это с названием хромосома (1888). Можно сказать, что омиковая революция началась столетие тому назад охотой за полным набором наследуемых полианионов.

Теперь данные больше не ведут к гипотезе, но делают гипотезы ненужными. Больше нет нужды беспокоиться, что есть причина, а что следствие, эффект — это и есть причина. Гленн Эванс писал в начале омиковой революции, что когда омиковый эксперимент закончен, данные могут быть введены в модель, и она начнет работать [19]: «Основываясь на более глубоком понимании сетей генов, системных правил, чем те, которые сейчас доступны, симуляция (моделирование) обеспечит конструирование млекопитающего in silico. In silico veritas! Чип [компьютерный — Е.С.], вот что сделало возможными и „омики“, и системную биологию. Это бросает вызов традиции движимых гипотезами исследований, которые доминировали в науке, начиная с зарождения научной революции». Далее автор много говорит о научных революциях и их героях, о санитарной революции и высказывает оптимистический (мне кажется, что это иронически-скептический оптимизм, но он передает дух и стиль энтузиастов омиков и системной биологии) тезис: «Я готов поспорить, что прямо сейчас, сегодня, есть данные, которые говорят о том, как лечить тех, кто умирает от болезней... Я готов спорить, что они прячутся где-то in silico, в этих ярких растущих картах взаимодействий, в шахтах, образуемых парами оснований, в киберпространстве, в веб-сайтах, посвященных геномике, фармакогеномике, убикитомике и т.д. Некоторые из этих омиков точно приведут нас к Ангелу лечения. Это моя гипотеза».

Могут ли Big Data означать конец теории в науке?

В названии этого раздела я использовал заголовок статьи [20], опубликованной в 2015 г.

Вот ее начало: «Несколько лет назад Крис Андерсон, бывший главный редактор журнала Wired, опубликовал провокационную и заставляющую задуматься статью: „Конец теории: потоп данных делает научный метод устаревшим“. Как видно из названия, Андерсон утверждал, что в эпоху информации, петабайт и суперкомпьютеров традиционный, управляемый гипотезами, научный метод станет устаревшим. Нет больше теории или гипотезы, нет больше дискуссий, опровергающих или поддерживающих экспериментальные результаты оригинальных гипотез. В эту новую эпоху то, что имеет значение, — это сложные алгоритмы и статистические инструменты, используемые, чтобы просеять огромное количество данных, чтобы найти информацию, которая может быть превращена в знания. Согласно этой точке зрения, новый „независимый от гипотез“ способ получения нового знания заменит традиционный попперовский, ориентированный на выдвижение и проверку гипотез подход. Анализ огромных объемов данных даст новые и часто неожиданные корреляции, шаблоны и правила, при этом никакая теория исходно не требуется. Подход, основанный на данных, можно рассматривать как генерирующий гипотезы, в отличие от гипотез-тестирующего подхода классической науки, о котором мы с вами говорили, обсуждая идеи Карла Поппера».

Такой подход был провозглашен еще на заре геномики, при появлении технологии микрочипов, которая, в сущности, была первым шагом на пути к Big Data в геномике [21]. «Это эксплоративный подход, которым пользовались мореплаватели, пускаясь в кругосветное путешествие и открывая в процессе него новые территории, не выдвигая исходно никаких гипотез о том, где эти территории могут находиться. Эксплорация (разведка) означает осмотр окружающего, наблюдение, описание и картирование неоткрытых территорий, без тестирования теорий или моделей. Целью является обнаружить вещи, которых мы не знали и не ожидали, и увидеть связи между элементами, вне зависимости от того, подозревались они ранее или нет. Отсюда следует, что этот процесс не обусловлен гипотезами и должен быть, насколько это возможно, независимым от моделей. Мы должны использовать беспрецедентные экспериментальные возможности, которые обеспечивают геномные последовательности, для того чтобы по-новому, всеобъемлюще и непредубежденно, взглянуть на любой вопрос биологии. Если нам это удастся, мы можем ожидать, что многие из новых моделей, которые возникнут, будут противоречить общепринятым».

Продолжая рассуждения Андерсона можно сказать, что Big Data возложат большую роль на корреляции, которые давно используются в науке в качестве отправной точки для дальнейшего исследования. Корреляции не предполагают причинно-следственных связей. Но в данном случае предполагается примат корреляций над причинно-следственными связями или, еще более радикально, замена причинно-следственных связей корреляциями. Говоря словами Андерсона: «петабайты позволяют нам сказать: „корреляции достаточно“. Мы можем прекратить искать модели. Мы можем анализировать данные без гипотез о том, что они могут показывать. ... Корреляция заменяет причинную связь, и наука может продвинуться даже без моделей, объединяющих теорий, и без каких-либо объяснений механизмов вообще».

Андерсоновский «конец теории» стимулировал интересную дискуссию и оказался очень эффективной провокацией. В то же время, его постановка вопроса упрощает несколько важных аргументов, которые должны быть рассмотрены более внимательно.

Может ли подход, руководствующийся только данными, являться новым инструментом для научных исследований?

Согласно умеренным сторонникам концепции Андерсона, корреляции следует рассматривать с точки зрения исследователя, который будет выдвигать гипотезы о возможном или невозможном функциональном смысле этих корреляций. Подход, руководствующийся только данными, может являться новым инструментом для научных исследований. Тем не менее, это не означает, что он заменит познавательные и методологические процедуры, которые были выработаны в течение многих веков философской и научной мысли. Это не «конец теории», но появление новых возможностей. Рассматривать проблему развития науки нельзя только с точки зрения гипотезонаправляемой или управляемой только данными. Обе эти стратегии необходимы и должны дополнять друг друга. Индуктивный и дедуктивный подходы следует рассматривать как фазы повторяющегося цикла приобретения знаний. Накопление громадных объемов данных не означает, что творческий человек перестал быть обязательным компонентом в научной деятельности. Творчество отличается и от механических вычислений, и от тривиального видения вещей и событий. Оно включает в себя исследование новых способов установления связей, в том числе такие заключения, которые кажутся неправдоподобными с точки зрения здравого смысла, принятых догм. Часто из решений, выглядящих неправдоподобно, возникают подлинно новые перспективы и идеи.

Как сформулировал Л. Перельман: «Догма — это жертва мудростью во имя логики». Но, тем не менее, есть много аргументов против. Посмотрим на них еще раз.

Big data, но готовы ли мы?

Идут дискуссии, в которых обсуждаются технические возможности современных методов работы с Big Data [22], [23]. Авторы приходят к выводу, что с имеющимися в настоящее время технологиями хранения и обработки данных в биологии пока невозможно в разумные промежутки времени обрабатывать пета и экзабайтовые объемы информации, которую производят высокоскоростные экспериментальные методы геномики, протеомики и других омик. Я не профессионал и, полагаясь на мнение специалистов [22], попытаюсь указать на принципиальную невозможность использования Big Data как таковых для выработки научных концепций и для научных открытий.

Big Data и принцип неопределенности в биологии

Рассмотрим для начала специфику данных в биологии. Все эти данные в огромном большинстве случаев получаются in vitro, и характер их связи с тем, что происходит в клетке, совершенно неочевиден. Мы сталкиваемся с принципом неопределенности (дополнительности) в биологии.

Бор предполагал, что принцип дополнительности применим к биологии, и даже думал, что может оказаться невозможным в полной мере объяснить жизненные процессы в физическом выражении. Но даже если Бор был неправ, он, тем не менее, обращал внимание на биологически важный принцип. Ученик Бора, нобелевский лауреат Макс Дельбрюк, считал, что молекулярная структура и комплексная биологическая функция могут быть несовместимыми характеристиками. Для определения структуры, как правило, требуется молекулярная однородность, в то время как определение сложной биологической функции обязательно требует гетерогенной клеточной или организменной среды.

Таким образом, в биологии мы приходим к заманчивому сходству с квантовыми системами. Так же как и в квантовой механике, зависимость результата наблюдения от взаимодействий между измерительным прибором и объектом составляет неотъемлемую часть процесса измерений, так что они находятся в своеобразном дополнительном отношении друг к другу. Для биологических объектов на это намекали Бор, Дельбрюк и их коллеги.

Как и для квантовой неопределенности, любая попытка изучить систему обязательно изменит характер исследуемой системы (это называется эффект наблюдателя). Нильс Бор отмечал, что изучение биологического организма, например, путем разрушения его на части, изменяет его природу по сравнению с исходным организмом. В случае клеточной биологии, К. Поттен и М. Лоеффлер [24] впервые указали на «клеточную неопределенность» в случае стволовых клеток. Таким образом: «Одна из основных трудностей при рассмотрении стволовых клеток заключается в том, что они определяются с точки зрения их функциональных свойств, которые можно оценить только путем тестирования особенностей клеток, которые могут измениться во время процедуры анализа. Это ситуация, аналогичная принципу неопределенности в физике». Эта неопределенность может быть уменьшена, но не устранена.

Чрезвычайно важно заметить, что все биологические системы (как сложные системы) являются чрезвычайно чувствительными к любому возмущению. Самый незначительный акт исследования обязательно в какой-то степени вовлекает наблюдателя в изменение исследуемой системы, будь то путем изменения микроокружения клеток, либо путем введения внутрь клетки зонда для визуализации [25]. И эта чувствительность предопределяет крайне неоднородный, трудновоспроизводимый и, следовательно, сложный для математического моделирования характер Big Data. Больше информации относительно идеи дополнительности в биологии читатель может найти в обзорах [25], [26].

Наука, управляемая данными, является химерой

Встанем теперь на точку зрения, высказанную в статье он-лайн Don’t believe the petabytes! Against Big Data Empiricism. Ее автор говорит: «Давайте поставим все обратно с головы на ноги. Именно потому, что каждый день становится доступным все большее количество данных, мы все больше нуждаемся в лучших моделях, теориях и гипотезах».

Поппер (1963 г.) сказал нам, что совершенно бессмысленно коллекционировать наблюдения и надеяться, что будто каким-то образом выявятся сходства в наблюдениях, и это позволит появляться хорошим теориям.

Большинство массивов больших данных, например, значительная часть данных по биоразнообразию или геномике, представляют собой списки, каталоги и классификации. А вопрос, который на самом деле критически важен, возможно ли делать научные открытия, узнавать что-то новое, такое, что выходит за рамки новых данных и тривиальных дедуктивных выводов, чтобы новые теории, объяснения и прогнозы стали бы доступны. Стандартный взгляд в философии науки, начиная с Поппера и более ранних философов, заключается в том, что в то время как существует «логика научного обоснования» (т.е., методы тестирования научных теорий, как только они становятся доступными), «логики научного открытия» (то есть, рутинного способа получения новых ценных научных теорий) не существует [5], весьма часто это происходит случайно. Можно ли надеяться, что Big Data выработают такую логику? Вопрос в том, чтобы понять: могут ли Big Data позволить делать открытия, определять ценность или осуществлять проверки универсальных научных теорий, орудий исследования, или делать индуктивные выводы? И могут ли Big Data способствовать опровержению теорий или гипотез [5]?

Будем осторожны с выводами. Конечно, компьютеры имеют жизненно важное значение сегодня и будут занимать всё большее место в будущей науке. Они могут почти мгновенно тестировать тысячи гипотез и моделей. Анализ сотен тысяч последовательностей в области геномики, безусловно, невозможен без вычислительной мощности. Но все-таки самое большее из того, на что способен компьютер, скорее всего будет представлять собой проверку предположений (гипотез) экспериментом, только усиленную компьютером [5]. Автор работы [5] более резок в высказываниях: «Возможно ли что наука, управляемая Big Data, позволит делать открытия? Такие стремления подобны ныне дискредитированному индуктивистскому подходу к науке. С положительной стороны, Big Data может позволить работать с большими размерами выборок, дешевле и более широко тестировать теории. С негативной стороны, наука, движимая данными (data-driven science), поощряет пассивный сбор данных, в отличие от экспериментов и испытаний, а также одурачивание (hornswoggling, придание значимости „несостоятельным статистически не значимым эффектам“). Наука, управляемая данными, является химерой».

И в заключение: «Есть основания полагать, что наука, управляемых данными, будет обнаруживать много ложных связей. Это может легко привести к апофении (ложному выявлению связей между несвязанными явлениями) и чудовищной вспышке самоодурачивания» [5].

М. Фрике [5] далеко не одинок в своем скептицизме относительно потенциала Big Data как замены анализа, основанного на гипотезах. В детальной статье «Ложное обещание больших данных: может ли интеллектуальный анализ данных (Data Mining) заменить основанное на гипотезах познание в идентификации прогнозных показателей эффективности [производственной деятельности]?» (The false promise of Big Data: Can data mining replace hypothesis-driven learning in the Identification of predictive performance metrics?) говорится следующее: «Распространенное мнение о том, что интеллектуальный анализ данных может помочь менеджерам [Исследователям. — Е.С.] найти рецепты успеха — это фантазия. Анализ данных может проверить какие-либо свойства системы, потенциально пригодные для прогнозирования или управления сложными процессами после того, как эти свойства идентифицированы. Но он не может заменить основанное на гипотезах выявление [этих свойств]». Остановлюсь здесь. Читатель может обратиться к цитируемым статьям для более детального знакомства с аргументацией.

Факты под подозрением. Период полураспада фактов

Нет ни одной идеи, относительно которой я был бы уверен, что она выдержит испытание временем.

А. Эйнштейн

Мысль, высказанная Эйнштейном, может быть отнесена и к фактам. Эдвард Теллер очень разумно сказал: «Факт есть простое утверждение, которому каждый верит. Он вне подозрений, если не признан ложным». К сожалению, очень часто в науке факты оказываются либо ложными, либо неполными. Так что гипотезы, которые базируются на них, заведомо неверны. Я приведу пару выдержек из интересной статьи в газете Economist (от 28 ноября 2012 г.) которая называется «Время полураспада фактов». Статья повторяет навание книги, написанной математиком из Гарварда Самуилом Арбесманом):

«В начальной школе Бэббидж (1791–1871, английский математик, философ, изобретатель викторианской эпохи) узнал, что в Солнечной системе девять планет. Ни одной планеты, как известно, не существует вне ее. С тех пор, астрономы заметили более 800 планет вокруг других звезд (и еще тысячи „кандидатов“). Даже беглый взгляд на другие области науки показывает аналогичные модели».

Когда Арбесман говорит, что факт имеет период полураспада, он подчеркивает, что изменения в восприятии фактов аналогичны радиоактивному распаду. Если мы возьмем один атом урана, можно сказать, что он в конечном итоге распадется, хотя когда это произойдет, невозможно предсказать. Это может быть в следующие полсекунды, а может быть и через миллион лет. Но всё меняется, когда вы переходите от одного атома к большому количеству атомов. Если у вас есть большой кусок урана, вы можете сказать, что за 4,47 миллиарда лет половина атомов в нем распадется. По мнению Арбесмана, то же верно и для науки, и знания в целом. Даже если нельзя предсказать, что некое открытие будет сделано, или что данный факт будет дискредитирован, есть закономерности в том, как растет и изменяется знание с течением времени.

Например, в области медицинской науки, занимающейся проблемами гепатита и цирроза печени, исследователи посмотрели, сколько времени занимало опровержение половины фактов в этих областях. Не буду рассказывать об их методах определения этой скорости, но вывод таков: каждые 45 лет половина знаний в этой области устаревает.

Эти скорости, конечно, меняются со временем и различны в различных областях. Например, когда медицина трансформировалась из искусства в науку, период полураспада был гораздо более быстрым, чем в настоящее время. Тем не менее, медицина до сих пор имеет очень короткий период полураспада; на самом деле это одна из областей, где знания меняются очень быстро. В математике это происходит гораздо медленнее. Но мы с вами говорим о биологии, и здесь, по-видимому, скорость изменения знаний еще выше, чем в медицине.

Всё время происходит изменение фактов, точнее, нашего знания о фактах. Это означает, что всё время происходят изменения в производных фактов — гипотезах, и наступает момент, когда изменения в фактах опровергают гипотезы. Это нормально, проблема в том, что часто мы не в состоянии признать изменения. А иногда — не хотим. Мой вышеприведенный рассказ о выдающемся творце парадигмы негативной регуляции — не одинок.

Я хорошо помню, как в начале 1960-х на знаменитой и замечательной Школе по молекулярной биологии в Дубне нам, молодым пришельцам в эту область, солидные профессора рассказывали, как происходит репликация ДНК с помощью одного только фермента ДНК-полимеразы. С тех пор наука узнала о многих десятках, если не сотнях участников этого процесса.

Вот еще один пример [29].

Исторически сложилось, что научный метод, используемый в западной медицине, происходит от микробной (м.б. лучше сказать зародышевой) теории болезней, где один патогенный фактор, например, микроорганизм, вызывает один определенный тип болезни. Эта парадигма была основой медицинского образования в США и Канаде и сильно повлияла на медицинскую практику, диагностические критерии (на основе постулатов Коха) и мышление. Неадекватность микробной теории для рака стала все более широко осознаваться в 1980-х годах, с появлением «двухударной» гипотезы развития рака — в отличие от «одноударной» микробной теории. Это была гипотеза, известная сейчас как гипотеза Кнудсона, последующее развитие которой привело к современной гипотезе, что рак — это результат накопления мутаций в клетке. Мы в разделе, посвященном раку, увидим, что и эта гипотеза недостаточна для объяснения причинно-следственных событий при развитии рака. Но тогда это был важнейший шаг к пониманию происхождения рака, приведший к одной из крупнейших смен парадигм в медицине. Работы Кнудсона, в конечном счете, привели к выявлению генов, вовлеченных в возникновение рака. Осознание важности множества взаимодействующих факторов привело к представлению о сложных болезнях, к которым относится большинство неинфекционных заболеваний.

Сегодня многие факты имеют еще меньший период существования, поскольку очень остро стоит вопрос о невоспроизводимости опубликованных данных и об их частой фальсификации. Остановлюсь на этом очень коротко, имея в виду, что я собираюсь об этом еще говорить в главе, посвященной системной биологии и персонализированной медицине. (А пока читатель может воспользоваться дополнительной информацией из работы [5].)

Ловушка правдоподобия

Здесь нужно упомянуть о таком соблазне для исследователей, как «ловушка правдоподобия» (plausibility trap) ) [30]. Это широко распространенная ловушка, когда количественно правдоподобное объяснение, при этом не имеющая ничего общего с реальностью (например, модель, основанная на определенной гипотезе), принимается без должной экспериментальной проверки за истину состояния. Лучший ее пример — геоцентрическая модель Птолемея. Говоря о биологии, наиболее влиятельной является «ловушка», что «Статистическая значимость = p ≤ N (N может, в зависимости от предмета исследования, варьироваться от 0,05 до менее 10-20)». В этом последнем случае причинно-следственная связь заменяется корреляцией. Это, кстати, также системная биология, обещающая большой прорыв во всемогущей персонализированной медицине (этой проблеме посвящена специальная глава). Вычислительные модели полезны для выбора направлений экспериментального исследования и для анализа и интерпретации данных. Но при этом в соответствии с идеями Карла Поппера наиболее ценно, когда модель не согласуется с экспериментом. При всей кажущейся парадоксальности — именно в этом случае начинается формирование новых гипотез и взглядов на проблему. Модели — это всегда упрощенные представления реальности. Известное высказывания Джорджа Бокса (1919–2013, английский статистик): «Все модели являются неправильными» — отражает их неизбежную упрощенность. Это выражение часто цитируют. Но далее Бокс продолжал так: «Практический вопрос заключается в том, в какой степени неправильными они должны быть, чтобы оставаться полезными». Это проблема постоянной экспериментальной проверки.

Неизбежные ошибки технологии искажают факты

Я постараюсь усилить доводы в пользу невозможности замены гипотезо-движимой науки наукой, движимой Big Data, процитировав и прокомментировав выдающегося ученого в области онкологии Роберта Вайнберга [31].

Его точка зрения была изложена в статье под названием «Гипотезы сначала» (Point: Hypotheses first), опубликованной в Nature 1 апреля 2010 г. Я приведу некоторые выдержки из нее в сокращенном варианте.

«Мало есть такого, что можно было бы продемонстрировать [обществу — Е.С.] за все время и деньги, вложенные в геномные исследования рака, и этот подход подрывает испытанные пути исследования и организации науки.

Исследования, основанные на выдвижении гипотезы и ее проверке (hypothesis-driven research), хорошо служили нам последние полстолетия и привели к революциям в молекулярной и клеточной биологии, иммунологии, нейробиологии и генетике. Наше понимание механизмов патогенеза превзошли самые дерзкие спекуляции, которые имели место 50 лет назад.

Теперь подобные исследования под угрозой. Многие полагают, что традиционные средства не могут расшифровать грандиозную сложность, которая позволяет преуспевать отдельной клетке и сложному организму. Полагают, что недавно появившиеся технологические инновации породили альтернативный путь расшифровки. Мои студенты могут собрать определенные типы данных в 1000 и даже в 10 000 раз быстрее, чем я мог это сделать 40 лет назад.

В исследованиях рака новые технологии обещают изменить пути диагностики, терапии и понимания патогенеза болезни. Так что же, старые пути научной работы — тестирование гипотез — стали анахронизмом? Я думаю — нет.

Эра новой биологии — геномики, протеомики и метаболомики — началась с секвенирования генома человека. Успех этого проекта бесспорен: десятки тысяч исследовательских программ, многие из которых сфокусированы на идентификации и характеристике определенных генов, выиграли очень сильно от создания и изучения этой базы данных. [На мой взгляд, здесь автор иронизирует — Е.С.]

Крупномасштабные проекты, такие как „Геном человека“, выдают за будущее и... часть системной биологии [см. том 1 моей книги. — Е.С.], которая появилась недавно. Увеличивающаяся часть национального исследовательского бюджета направляется на эти цели. Но стоит ли уничтожать 20 или 30 маломасштабных проектов, основанных на проверке гипотез, ради того, чтобы освободить место исследованиям на системном уровне?

С точки зрения исследований рака (Вайнберг — признанный авторитет в этой области — Е.С.) успехи гипотезо-направляемых исследований ясны и бесспорны. Они продолжаются, начавшись более чем полувека назад, и продолжают давать новые концептуальные результаты неделя за неделей, месяц за месяцем. Напротив, новые пути развития биологии настолько неопробованны, что их долговременные преимущества еще трудно предвидеть.

Секвенирование полных геномов опухолей (или их экзонов) ... потребляют огромные ресурсы и энергию исследователей. Но дивиденды на сегодняшний день скромны: открытие нескольких новых онкогенов и генов опухолевых супрессоров ... и определение степени нестабильности различных геномов опухолевых клеток. Эти массивные проекты по производству данных еще только намереваются дать понятный консенсус относительно того, как много мутаций требуется, чтобы породить человеческую опухоль, и дали нам мало крупных прорывов в нашем понимании, как развивается индивидуальная опухоль. Цена каждого концептуального понимания была очень высокой, хотя это может измениться с падением стоимости технологии. Тем временем много меньшие экспериментальные исследовательские программы, которые являются проверенным источником концептуальных инноваций, борются за выживание.

Вероятно, наиболее амбициозные крупномасштабные мероприятия включают в себя сборку многих взаимодействующих сигнальных компонентов в клетке в „электромонтажные схемы“ (wiring diagrams). Эти сложные карты, иногда называемые клубками шерсти (hairballs), и компьютерные алгоритмы, которые моделируют сигнальные процессы, могли бы пролить свет на то, почему и как индивидуальные клетки откликаются на внешние сигналы, и предсказать их будущее поведение. Будучи эстетически привлекательными, они внесли лишь малый вклад в концептуальное понимание причин того или иного поведения клетки. Некоторые полагают, что детальное понимание отдельных компонентов сигнальных систем является пререквизитом (предпосылкой) для предсказания поведения целых сигнальных схем.

Ставки здесь велики. Последствия сдвига финансирования, предоставляемого основными финансовыми агентствами, будут ощущаться последующими поколениями ученых. Руководство лабораториями, фокусирующимися на маломасштабных проектах, движимых гипотезами, стало непривлекательным для многих молодых ученых из-за громадных трудностей в получении денег на такие проекты. Долговременным последствием этого будет неспособность многих биологических дисциплин привлечь ярких молодых людей, которые являются двигателями научного прогресса. Без них — мы пропали».

Надо отметить, что в этом же журнале рядом с Вайнбергом фигурирует мнение Тодда Голуба [32], которое идет под заголовком Counterpoint: Data First. Я позволю себе не цитировать его. Оно понятно из заголовка и на данный момент является мнением тех ученых, которые коллекционируют данные и пытаются на их основании делать функциональные выводы. На мой взгляд, Вайнберг корректно оценил успехи этого направления на сегодняшний день. Что касается исследований рака, то я попытаюсь в соответствующей главе показать, что геномика принципиально не может дать ответов на развитие опухоли и ее метастазирование.

Мы тонем в море данных, и все-таки мы томимся от жажды

Наконец не могу удержаться от соблазна привести высказывание еще одного нобелевского лауреата Сиднея Бреннера, одного из самых ярких и оригинальных исследователей современности. Вот что он сказал, выступая в 2008 году на симпозиуме в Индии: «Молодые ученые не должны соблазняться системной биологией, где данные являются заменителями мышления... Существует кризис во всех науках в наши дни. Мы тонем в море данных, и все-таки мы томимся от жажды. Сегодня наука вознаграждает только тех, кто коллекционирует и распределяет данные. Нет награды тем, кто организует данные и строит на их основе теории».

Я привел эти цитаты, чтобы дать почувствовать накал страстей (они проходят мимо нас, поскольку у нас другие денежные масштабы и, соответственно, гораздо более узкий горизонт для анализа).

Многие подумают, что это просто борьба поколений. Вайнберг, Альбертс — люди старшего поколения. Грин и другие геномные апологеты — молодое поколение. Всегда люди старого поколения, даже великие умы, воевали против новых идей и открытий, сопротивлялись новшествам: лорд Кельвин — против расщепления атомов и электромагнитной теории света. Дэви — против Дальтона, выдвинувшего закон кратности отношений. Гюйгенс и Лейбниц — против теории тяготения Ньютона. Рентген запрещал употреблять в своей лаборатории слово «электрон». Кювье, Пастер, Вирхов, Клод Бернар против теории эволюции Дарвина. Изобретатель паровой машины Джеймс Уатт, выступая против нового варианта паровой машины, изобретенной его соотечественником Ричардом Тревитиком, говорил, что это идет во вред прогрессу, и что Тревитика мало повесить за его изобретение.

Но в данном случае, на мой взгляд, дело обстоит гораздо хуже. Новые массированные подходы могут иметь принципиальный барьер, который невозможно преодолеть. Я думаю, что мы сильно недооцениваем степень этой неприятности. И я попытаюсь объяснить почему.

Факты устаревают. Эпигенетическая революция может восстановить [значимость] одного из самых старых соперников Дарвина

Человек, чьи ошибки требуют десятки лет для исправления, — великий человек.

Дж. Р. Оппенгейм (с изм.)

Да, повторюсь, факты устаревают, их заменяют новые и, соответственно, появляются новые гипотезы. Наиболее потрясающим событием такого рода в нашей области является признание эпигенетической наследственности. Приведу в качестве примера статью «Месть Ламарка: Эпигенетическая революция может восстановить [значимость] одного из самых старых соперников Дарвина»:

«Если есть загробная жизнь, то кажется, что Жан-Батист Ламарк может торжествовать. Его жизнь шла на первых порах достаточно хорошо и на поле боя, и в лаборатории. Ламарк был сторонником эволюции за много десятилетий до Дарвина, он придумал (с другими учеными) эволюционное дерево и даже термин „биология“. Но ко времени, когда Ламарк умер, он был без гроша в кармане и почти в одиночестве, высмеиваемый большинством его окружения, члены которого знали, вне всякого сомнения, что виды фиксированы и неизменны. За 30 лет до появления Дарвиновской книги „Происхождение видов“ Ламарк умер слепым и больным.

Вы, возможно, помните, что Жан-Батист Ламарк предложил механизм эволюции, в которой организмы передают признаки, приобретенные в течение их жизни, своему потомству. Например, можно предположить механизм эволюции жирафа: если жираф вытягивает шею, чтобы достичь более высоких листьев на дереве, потомки жирафа будет обладать несколько более длинной шеей».

Предложенный Ламарком механизм эволюции был проверен Вейсманом. Он отрезал хвосты мышей и размножал этих бесхвостых. Если Ламарк был прав, то следующее поколение мышей должно родиться без хвостов. Но у потомства были хвосты.

Рисунок 2. Фрагмент статьи в газете Guardian, посвященный проблеме возможности наследования приобретенных признаков.

Под давлением этих фактов теория Ламарка умерла и забыта уже более 100 лет, но вот сегодня этот непреложный факт подвергается сомнениям. Есть данные, что эпигенетика влияет на наследование признаков, например мыши с приобретенным страхом к ацетофенону имели потомков, более чувствительных к его запаху. Появляются статьи, подобные той, фрагмент из которой я привел на рис. 2. Но это уже другая история.

Литература

- S. Brenner. (2012). The Revolution in the Life Sciences. Science. 338, 1427-1428;

- Peter Lipton. (2005). The Medawar Lecture 2004 The truth about science. Phil. Trans. R. Soc. B. 360, 1259-1269;

- William F. McComas. (). The Principal Elements of the Nature of Science: Dispelling the Myths. The Nature of Science in Science Education. 53-70;

- Root Gorelick. (2011). What is theory?. IIEE;

- Martin Frické. (2015). Big data and its epistemology. J Assn Inf Sci Tec. 66, 651-661;

- Paul Cooper. (2017). Data, information, knowledge and wisdom. Anaesthesia & Intensive Care Medicine. 18, 55-56;

- Martin Frické. (2009). The knowledge pyramid: a critique of the DIKW hierarchy. Journal of Information Science. 35, 131-142;

- Samuel E. Gluck. (1960). KARL L. POPPER. The Logic of Scientific Discovery. Pp. 479. New York: Basic Books, 1959. $7.50. The ANNALS of the American Academy of Political and Social Science. 328, 212-214;

- Editorial. (2004). Don't fear the Robot Scientist. Nature. 427, 181-181;

- E. Pennisi. (2011). Will Computers Crash Genomics?. Science. 331, 666-668;

- Axel Meyer. (2011). On the Nature of Scientific Progress: Anarchistic Theory Says “Anything Goes”—But I Don't Think So. PLoS Biol. 9, e1001165;

- R. Berghmans, H. C. Schouten. (2011). Sir Karl Popper, swans, and the general practitioner. BMJ. 343, d5469-d5469;

- David J Glass. (2010). A Critique of the Hypothesis, and a Defense of the Question, as a Framework for Experimentation. Clinical Chemistry. 56, 1080-1085;

- David N. Stamos. (2007). Popper, Laws, and the Exclusion of Biology from Genuine Science. Acta Biotheor. 55, 357-375;

- Steve Fuller. (2002). The Structure of Scientific Revolutions (1962). Aust N Z J Psychiatry. 36, 824-827;

- D. Lehoux, J. Foster. (2012). A Revolution of Its Own. Science. 338, 885-886;

- Jon Beckwith. (2011). The Operon as Paradigm: Normal Science and the Beginning of Biological Complexity. Journal of Molecular Biology. 409, 7-13;

- Gerald Weissmann. (2009). Monumental Revolutions: Scientific, Sanitary and ʼOmicMonumental Revolutions: Scientific, Sanitary and ʼOmic. FASEB j.. 23, 3639-3643;

- Glen A. Evans. (2000). Designer science and the “omic” revolution. Nat Biotechnol. 18, 127-127;

- Fulvio Mazzocchi. (2015). Could Big Data be the end of theory in science?. EMBO Rep. 16, 1250-1255;

- Patrick O. Brown, David Botstein. (1999). Exploring the new world of the genome with DNA microarrays. Nat Genet. 21, 33-37;

- Oswaldo Trelles, Pjotr Prins, Marc Snir, Ritsert C. Jansen. (2011). Big data, but are we ready?. Nat Rev Genet. 12, 224-224;

- Eric E. Schadt, Michael D. Linderman, Jon Sorenson, Lawrence Lee, Garry P. Nolan. (2010). Computational solutions to large-scale data management and analysis. Nat Rev Genet. 11, 647-657;

- Potten C. S., Loeffler M. (1990). Stem cells: attributes, cycles, spirals, pitfalls and uncertainties. Lessons for and from the crypt. Development. 110, 1001–1020;